Esta ha sido hasta ahora mi última certificación aprobada. Es una certificación bonita, he de decir que aprendí bastante pero eran características que desconocía por completo del entorno Databricks, no obstante, creo que aunque es un buen reto para aprender este ha de ser enfocado principalmente a perfiles Data Analyst como tal, que trabajen con visualización o a Data Engineer versátiles que se mueven bien entre BI y Data Engineering o sencillamente un Data engineer con vocación al análisis.

El examen

Consta de 45 preguntas de selección multiple a resolver en 90 minutos

El mínimo para aprobar es un 70% lo cual se corresponde con 32 preguntas respondidas correctamente

Objetivos a cubrir en el examen

- Databricks SQL – 22% (10/45)

- Data Management – 20% (9/45)

- SQL – 29% (13/45)

- Data Visualization and Dashboards – 18% (8/45)

- Analytics Applications – 11% (5/45)

Siendo más específicos, la cualificación minima del candidato para aprobar debería ser la siguiente:

- Describe Databricks SQL and its capabilities, including:

- Databricks SQL (users, benefits, queries, dashboards, compute)

- Integrations (Partner Connect, data ingestion, other BI tools)

- Lakehouse (medallion architecture, streaming data)

- Manage data with Databricks tools and best practices, including:

- Delta Lake (basics, benefits)

- Storage and Management (tables, databases, views, Data Explorer)

- Security (table ownership, PII data)

- Use Structured Query Language (SQL) to complete tasks in the Lakehouse, including:

- Basic SQL (basic query structure, combining data, aggregations)

- Complex Data (nested data objects, roll-ups, windows, cubes)

- SQL in the Lakehouse (ANSI SQL, working with silver-level data, query history, higher-order functions, user-defined functions)

- Create production-grade data visualizations and dashboards, including:

- Visualization (Databricks SQL capabilities, types of visualizations, storytelling with data)

- Dashboarding (Databricks SQL capabilities, parameterized dashboards and queries, sharing)

- Production (refresh schedules, query alerts)

- Develop analytics applications to solve common data analytics problems, including:

- Descriptive Statistics (discrete statistics, summary statistics)

- Common Applications (data enhancement, data blending, last-mile ETL)

Mi opinión acerca del examen

Para empezar al examen le daría una ponderación de 5-5,5 sobre 10, es decir, me pareció un poco más sencillo que el Data Engineer Associate, eso si he de decir que tener conocimientos en el anteriormente mencionado me ha ayudado mucho a afrontar las preguntas de este examen. Dentro de las preguntas claves y conceptos a dominar de cara al examen recomiendo:

- Tener muy claro Lakehouse, características y ventajas. Arquitectura multihop/Medallion

- Cual es el Rol a llevar a cabo por un Data Analyst

- Qué es partner Connect y para que sirve? me sirve para conectar una herramienta de Bi?

- Repasar muy bien el entorno grafico y conocer las características, por ejemplo: Saber que el query editor, nos permite guardar y ejecutar consultas así como programar (schedule) un refresh de la consulta.

- Estudiar a fondo:

- Query

- Alert

- Visualization (tener claro todas las posibles, es el bar diagram los mismo que un histogram? cuáles son los pasos para crear una vista counter)

- Dashboard

- Tener muy en cuenta Refresh (Schedule) en: Quey, Alerts, Dashboards

- Gestión de permisos desde SQL y el Data explorer

- Habrán ejercicios de SQL que contemplen Join (left, right, inner, self, left anti) con incluso con operaciones de ventana (rank, dense_rank, row_number), repasar como tratar datos en SQL de tipo: Array, Json y operaciones como explode, coalesce, etc

Material de estudio:

- Hacer el curso de Data Lakehouse proporcionado por la misma página de Databricks academy (puedes darte de alta gratis como customer)

- Hacer el learning plan de Data Analyst Associate de la Databricks academy

- Revisar el GitHub de Databricks academy y hacer todos y cada uno de los ejercicios, allí también encontrarás las presentaciones.

- Documentación de Databricks

- Canal de Youtube de Databricks

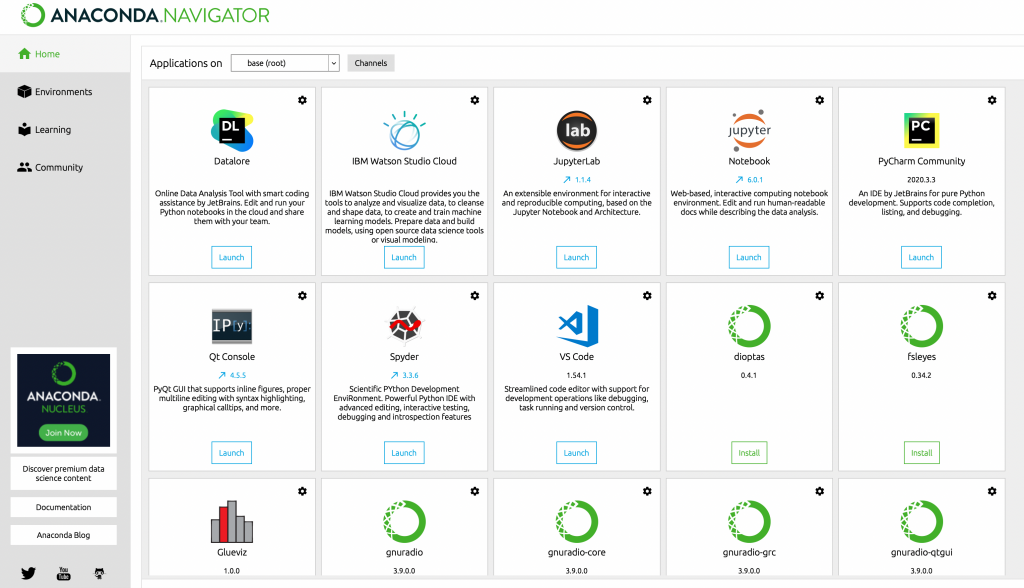

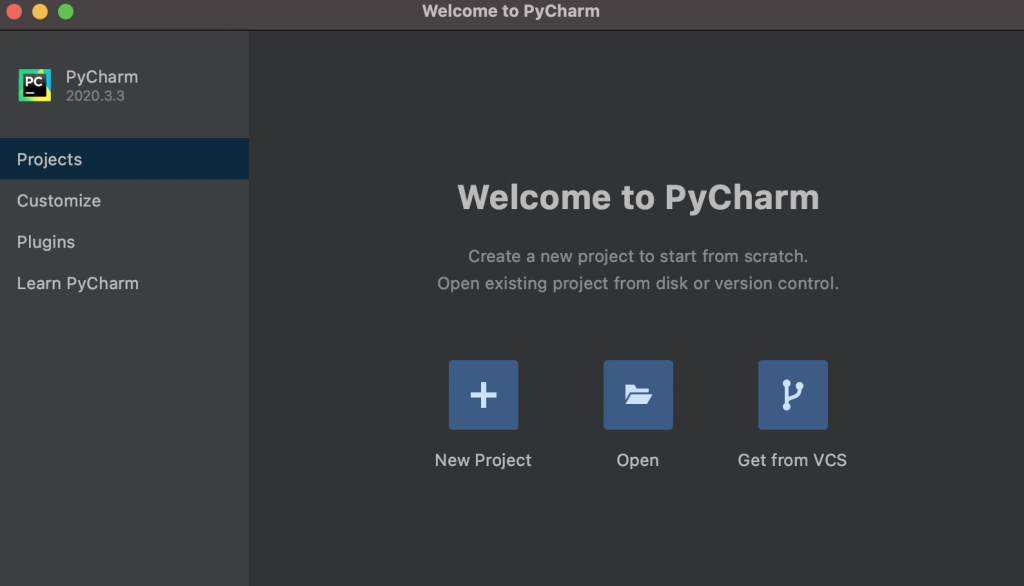

- En este caso la versión community no nos servirá para nada ya que el SQL workspace está presente únicamente en la versión de pago por lo cual para mitigar esta carencia intentando gastar lo mínimo hacer lo siguiente:

- Estar atento a los workshop que ofrece continuamente Databricks tanto en Azure como AWS y así podrás contar con un cluster a todo dar durante 4-5 horas.

- Aprovecha los free trial de 14 días tanto en AWS (marketplace) como en Azure.

Espero que este resumen les pueda ser de ayuda para aprobar el examen. Ahora es tu turno y cuéntanos cuál de todas las certificaciones de Databricks te llama la atención y una vez aprobada la Data Analyst Associate cuál será tu siguiente reto? La Data Analyst Professional, La Data Engineer Associate o la ML Practitioner.